| Nominiert für die »WOMEN OF THE YEAR«-Awards 2025! Kategorie: IT – CxO Vote for Carolina: https://www.fit-kongress.de/award Link anklicken/ zur Abstimmung/ jetzt starten /Women in IT/ CxO/ Carolina Heyder |

Nominated for the „WOMEN OF THE YEAR“ Awards 2025! Category: IT – CxO Vote for Carolina: https://www.fit-kongress.de/award Click the link / to vote / start now / Women in IT / CxO / Carolina Heyder |

| Alibaba Wan2.2 bietet die erste Open-Source Video-KI mit MoE-Architektur für Kinoqualität. | Alibaba’s Wan2.2 is the first open-source video AI with a MoE architecture that produces cinematic-quality results. |

|

Mit der Wan2.2-Serie etabliert Alibaba neue Standards in der KI-gestützten Videogenerierung. Die innovativen Open-Source-Modelle kombinieren Mixture-of-Experts-Technologie mit ästhetischer Optimierung. Damit können Kreative und Entwickler hochwertige Videos mit nur einem Klick produzieren – und das bei 50 % weniger Rechenaufwand als bei herkömmlichen Ansätzen.

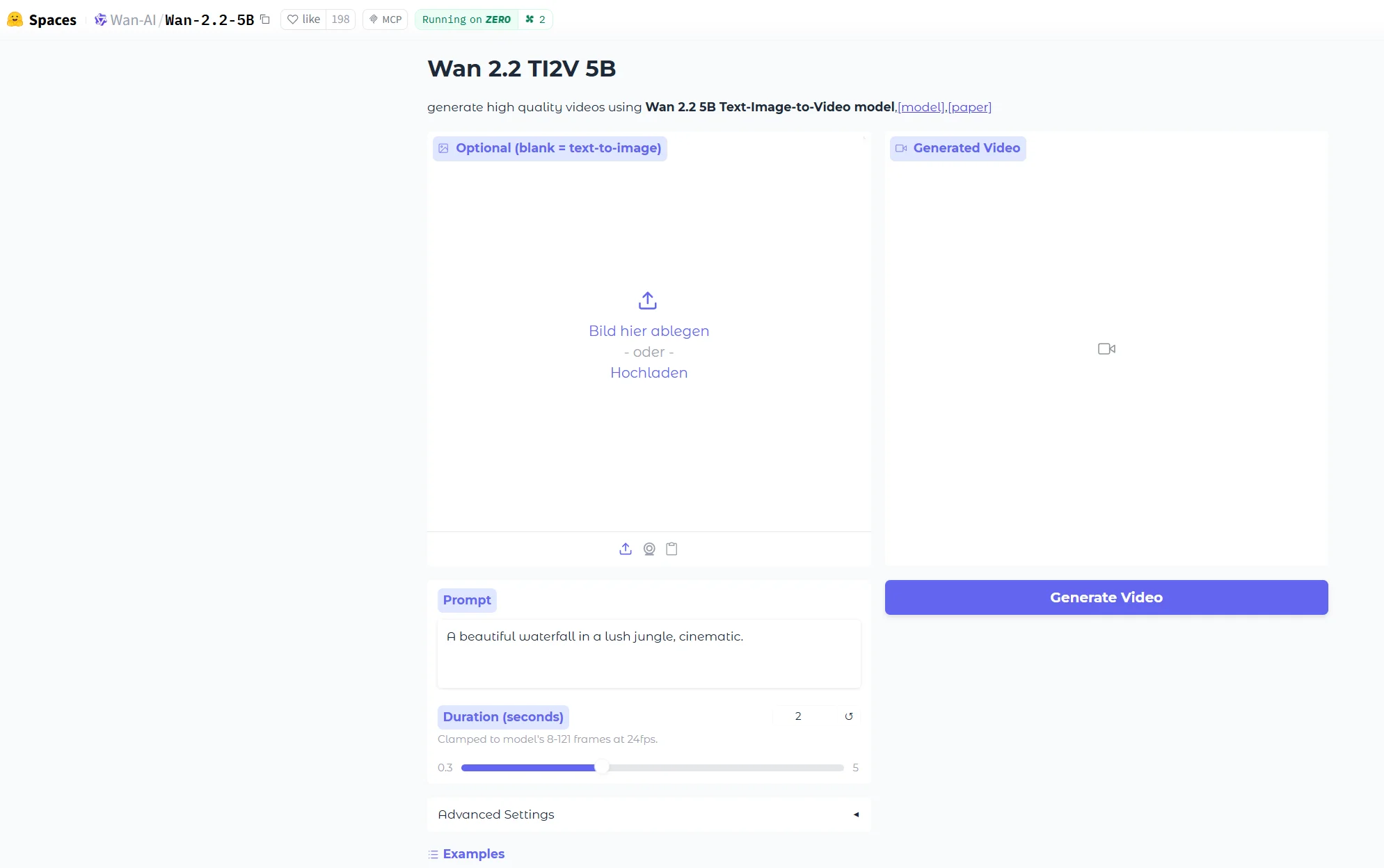

Die Wan2.2-Serie umfasst das Text-zu-Video-Modell Wan2.2-T2V-A14B und das Bild-zu-Video-Modell Wan2.2-I2V-A14B sowie Wan2.2-TI2V-5B, ein Hybridmodell, das sowohl Text-zu-Video- als auch Bild-zu-Video-Generierungsaufg

Wan2.2-T2V-A14B und Wan2.2-I2V-A14B basieren auf der MoE-Architektur und wurden mit sorgfältig ausgewählten ästhetischen Daten trainiert. Sie generieren Videos in Kinoqualität und mit einer hohen Ästhetik und bieten den Erstellern präzise Kontrolle über wichtige Dimensionen wie Beleuchtung, Tageszeit, Farbtöne, Kamerawinkel, Bildgröße, Komposition, Brennweite und mehr.

Die beiden MoE-Modelle zeigen auch deutliche Verbesserungen bei der Erzeugung komplexer Bewegungen – darunter lebhafte Gesichtsausdrücke, dynamische Handgesten und komplizierte Sportbewegungen. Darüber hinaus liefern die Modelle realistische Darstellungen mit verbesserter Befolgung von Anweisungen und Einhaltung physikalischer Gesetze.

Um den hohen Rechenaufwand bei der Videogenerierung durch lange Tokens zu bewältigen, implementieren Wan2.2-T2V-A14B und Wan2.2-I2V-A14B ein Zwei-Experten-Design im Denoising-Prozess von Diffusionsmodellen, darunter einen Experten für hohe Rauschwerte, der sich auf das gesamte Szenenlayout konzentriert, und einen Experten für niedrige Rauschwerte, der Details und Texturen verfeinert. Obwohl beide Modelle insgesamt 27 Milliarden Parameter umfassen, werden pro Schritt nur 14 Milliarden Parameter aktiviert, wodurch der Rechenaufwand um bis zu 50 Prozent reduziert wird.

Wan2.2 verfügt über eine fein abgestimmte ästhetische Optimierung durch ein von der Filmkunst inspiriertes Prompt-System, das wichtige Dimensionen wie Beleuchtung, Lichtverhältnisse, Komposition und Farbtöne kategorisiert. Dieser Ansatz ermöglicht es Wan2.2, die ästhetischen Absichten der Nutzer während des Generierungsprozesses genau zu interpretieren und umzusetzen.

Um die Generalisierungsfähigkeiten und die kreative Vielfalt zu verbessern, wurde Wan2.2 auf einem wesentlich größeren Datensatz trainiert, der im Vergleich zu Wan2.1 eine Steigerung der Bilddaten um 65,6 Prozent und der Videodaten um 83,2 Prozent aufweist. Wan2.2 zeigt eine verbesserte Leistung bei der Erzeugung komplexer Szenen und Bewegungen sowie eine verbesserte Fähigkeit zum künstlerischen Ausdruck.

Ein kompaktes Modell zur Verbesserung der Effizienz und Skalierbarkeit

Wan2.2 führt außerdem sein Hybridmodell Wan2.2-TI2V-5B ein, ein dichtes Modell, das eine hochkomprimierte 3D-VAE-Architektur nutzt, um eine zeitliche und räumliche Komprimierungsrate von 4x16x16 zu erreichen, wodurch die Gesamtinformationskomprimierun

Die Wan2.2-Modelle können auf Hugging Face und GitHub sowie in der Open-Source-Community ModelScope von Alibaba Cloud heruntergeladen werden. Als wichtiger Beitrag zur globalen Open-Source-Community hat Alibaba im Februar 2025 vier Wan2.1-Modelle und im Mai 2025 Wan 2.1-VACE (Video All-in-one Creation and Editing) als Open Source veröffentlicht. Bis heute wurden die Modelle auf Hugging Face und ModelScope über 5,4 Millionen Mal heruntergeladen. |

With the Wan2.2 series, Alibaba is setting new standards for AI-powered video generation. These innovative models combine mixture-of-experts technology with aesthetic optimization. This enables creatives and developers to produce high-quality videos in just one click — with 50% less computing effort than conventional approaches.

The Wan2.2 series feature a text-to-video model Wan2.2-T2V-A14B and image-to-video model Wan2.2-I2V-A14B, and Wan2.2-TI2V-5B, a hybrid model that supports both text-to-video and image-to-video generation tasks within a single unified framework. Built on the MoE architecture and trained on meticulously curated aesthetic data, Wan2.2-T2V-A14B and Wan2.2-I2V-A14B generates videos with cinematic-grade quality and aesthetics, offering creators precise control over key dimensions such as lighting, time of day, color tone, camera angle, frame size, composition, focal length, etc. The two MoE models also demonstrate significant enhancements in producing complex motions – including vivid facial expressions, dynamic hand gestures, and intricate sports movements. Additionally, the models deliver realistic representations with enhanced instruction following and adherence to physical laws. To address the issue of high computational consumption in video generation caused by long tokens, Wan2.2-T2V-A14B and Wan2.2-I2V-A14B implement a two-expert design in the denoising process of diffusion models, including a high-noise expert focusing on overall scene layout and a low-noise expert to refine details and textures. Though both models comprise a total of 27 billion parameters, only 14 billion parameters are activated per step, reducing computational consumption by up to 50%. Wan2.2 incorporates fine-grained aesthetic tuning through a cinematic-inspired prompt system that categorizes key dimensions such as lighting, illumination, composition, and color tone. This approach enables Wan2.2 to accurately interpret and convey users‘ aesthetic intentions during the generation process. To enhance generalization capabilities and creative diversity, Wan2.2 was trained on a substantially larger dataset, featuring 65.6% increase in image data and 83.2% increase in video data compared to Wan2.1. Wan2.2 demonstrates enhanced performance in producing complex scenes and motions, as well as an enhanced capacity for artistic expression. A Compact Model to Enhance Efficiency and Scalability Wan2.2 also introduces its hybrid model Wan2.2-TI2V-5B, a dense model utilizes a high-compression 3D VAE architecture to achieve a temporal and spatial compression ratio of 4x16x16, enhancing the overall information compression rate to 64. The TI2V-5B can generate a 5-second 720P video in several minutes on a single consumer-grade GPU, enabling efficiency and scalability to developers and content creators. Wan2.2 models are available to download on Hugging Face and GitHub, as well as Alibaba Cloud’s open-source community, ModelScope. A major contributor to the global open source community, Alibaba open sourced four Wan2.1 models in February 2025 and Wan 2.1-VACE (Video All-in-one Creation and Editing) in May 2025. To date, the models have attracted over 5.4 million downloads on Hugging Face and ModelScope. |

| Der neue Senior Director Partner Sales bei NetApp, Henning Rahe, erklärt im SSCG-Podcast mit Carolina Heyder, wie das Mittelstandsgeschäft gemeinsam mit Partnern gestärkt werden soll. | NetApp’s new Senior Director Partner Sales, Henning Rahe, explains in the SSCG Podcast with Carolina Heyder how the company plans to strengthen its midmarket business with partners. |

Dr. Jakob Jung ist Chefredakteur Security Storage und Channel Germany. Er ist seit mehr als 20 Jahren im IT-Journalismus tätig. Zu seinen beruflichen Stationen gehören Computer Reseller News, Heise Resale, Informationweek, Techtarget (Storage und Datacenter) sowie ChannelBiz. Darüber hinaus ist er für zahlreiche IT-Publikationen freiberuflich tätig, darunter Computerwoche, Channelpartner, IT-Business, Storage-Insider und ZDnet. Seine Themenschwerpunkte sind Channel, Storage, Security, Datacenter, ERP und CRM.

Dr. Jakob Jung is Editor-in-Chief of Security Storage and Channel Germany. He has been working in IT journalism for more than 20 years. His career includes Computer Reseller News, Heise Resale, Informationweek, Techtarget (storage and data center) and ChannelBiz. He also freelances for numerous IT publications, including Computerwoche, Channelpartner, IT-Business, Storage-Insider and ZDnet. His main topics are channel, storage, security, data center, ERP and CRM.

Kontakt – Contact via Mail: jakob.jung@security-storage-und-channel-germany.de