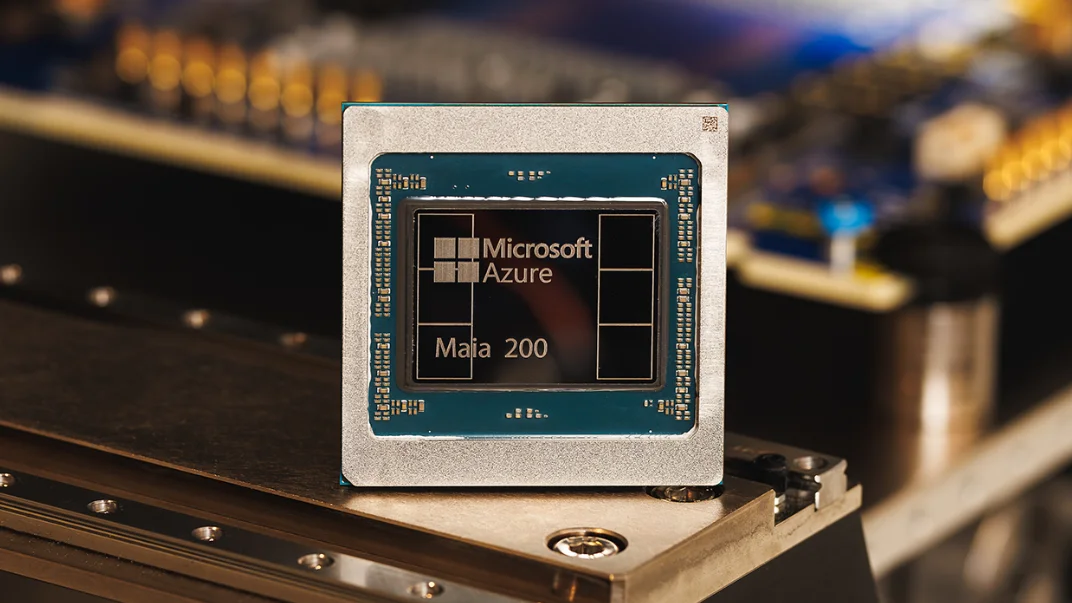

| Microsoft hat Maia 200 auf den Markt gebracht, einen KI-Beschleunigerchip auf Basis der 3-nm-Technologie, der eine um 30 % bessere Leistung pro Dollar als die bestehende Infrastruktur verspricht. | Microsoft has launched Maia 200, an AI accelerator chip built on 3nm technology that promises 30% better performance per dollar than existing infrastructure. |

| Microsoft hat Maia 200 vorgestellt, einen speziellen Chip, der die wirtschaftlichen Belastungen durch den Betrieb von KI-Inferenz-Workloads in großem Maßstab reduzieren soll. Der von Scott Guthrie, Executive Vice President of Cloud + AI, angekündigte Beschleuniger ist ein Versuch von Microsoft, einen eigenen Chip zu entwickeln, der mit den Angeboten von Amazon und Google konkurrieren kann.

Der Chip, der im 3-Nanometer-Verfahren von TSMC hergestellt wird, enthält über 140 Milliarden Transistoren und liefert laut Microsoft eine um 30 % bessere Leistung pro Dollar im Vergleich zur aktuellen Hardware in seiner Flotte. Laut Microsoft bietet Maia 200 die dreifache FP4-Leistung des Trainium-Chips der dritten Generation von Amazon und übertrifft die FP8-Leistung der TPU der siebten Generation von Google. Technische Architektur Maia 200 verfügt über native FP8- und FP4-Tensor-Kerne, die über 10 PetaFLOPS mit 4-Bit-Genauigkeit und über 5 PetaFLOPS mit 8-Bit-Genauigkeit bei einer Leistungsaufnahme von 750 W verarbeiten können. Das Speichersubsystem umfasst 216 GB HBM3e-Speicher mit einer Bandbreite von 7 TB/s sowie 272 MB On-Chip-SRAM. Das Design des Chips adressiert Herausforderungen bei der Datenbewegung, die typischerweise die Inferenzleistung einschränken. Microsoft hat spezielle DMA-Engines und eine maßgeschneiderte Network-on-Chip-Struktur entwickelt, um bei der Verarbeitung großer Sprachmodelle einen hohen Token-Durchsatz aufrechtzuerhalten. Auf Systemebene hat Microsoft ein zweistufiges Scale-up-Netzwerk entwickelt, das statt proprietärer Verbindungen Standard-Ethernet verwendet. Jeder Beschleuniger bietet eine bidirektionale Bandbreite von 2,8 TB/s und unterstützt Cluster mit bis zu 6.144 Beschleunigern. Vier Maia-Chips sind in Server-Einschüben mit direkten, nicht geschalteten Verbindungen für die lokale Kommunikation gruppiert. Bereitstellung und Anwendungen Microsoft setzt Maia 200 zunächst in seinem US Central-Rechenzentrum in der Nähe von Des Moines, Iowa, ein, als nächstes ist die Region US West 3 in der Nähe von Phoenix, Arizona, geplant. Der Chip wird die GPT-5.2-Modelle von OpenAI ausführen und die Dienste Microsoft Foundry und Microsoft 365 Copilot unterstützen. Das Superintelligence-Team des Unternehmens beabsichtigt, Maia 200 für die Generierung synthetischer Daten und für Reinforcement Learning zu verwenden. Microsoft gibt an, dass die Architektur des Chips eine schnellere Produktion domänenspezifischer Trainingsdaten für die Entwicklung zukünftiger KI-Modelle ermöglicht. Entwicklungsumgebung Microsoft veröffentlicht eine Maia SDK-Vorschau, die PyTorch-Integration, einen Triton-Compiler, optimierte Kernel-Bibliotheken und Zugriff auf die Low-Level-Programmiersprache des Chips umfasst. Das Toolkit bietet außerdem einen Simulator und einen Kostenrechner, mit denen Entwickler den Code vor der Bereitstellung optimieren können. Das Unternehmen verwendete Pre-Silicon-Modellierung, um die Systemarchitektur vor der Fertigung zu validieren. Laut Microsoft liefen KI-Modelle innerhalb weniger Tage nach Erhalt der verpackten Chips auf Maia 200, und die Zeit vom ersten Silizium bis zur Bereitstellung im Rechenzentrum betrug weniger als die Hälfte der Zeit vergleichbarer Infrastrukturprogramme. Microsoft hat Maia 200 mit integrierter Flüssigkeitskühlung und nativer Azure-Control-Plane-Konnektivität für Telemetrie, Diagnose und Verwaltung entwickelt. Das Unternehmen beschreibt sein Siliziumprogramm als generationsübergreifend, wobei zukünftige Iterationen bereits in der Entwicklung sind. Entwickler, KI-Startups und akademische Einrichtungen können sich über das spezielle Portal von Microsoft für die Maia SDK-Vorschau registrieren. |

Microsoft has introduced Maia 200, a specialized chip designed to reduce the economic burden of running AI inference workloads at scale. Announced by Scott Guthrie, Executive Vice President of Cloud + AI, the accelerator represents Microsoft’s attempt to build proprietary silicon that can compete with offerings from Amazon and Google.

The chip, manufactured on TSMC’s 3-nanometer process, contains over 140 billion transistors and delivers what Microsoft claims is 30% better performance per dollar compared to current hardware in its fleet. According to Microsoft, Maia 200 provides three times the FP4 performance of Amazon’s third-generation Trainium chip and surpasses Google’s seventh-generation TPU in FP8 performance. Technical Architecture Maia 200 features native FP8 and FP4 tensor cores capable of processing over 10 petaFLOPS in 4-bit precision and over 5 petaFLOPS in 8-bit precision within a 750W power envelope. The memory subsystem includes 216GB of HBM3e memory operating at 7 TB/s bandwidth, alongside 272MB of on-chip SRAM. The chip’s design addresses data movement challenges that typically limit inference performance. Microsoft engineered specialized DMA engines and a custom network-on-chip fabric to maintain high token throughput when processing large language models. At the system level, Microsoft developed a two-tier scale-up network using standard Ethernet rather than proprietary interconnects. Each accelerator provides 2.8 TB/s of bidirectional bandwidth and supports clusters of up to 6,144 accelerators. Four Maia chips are grouped in server trays with direct, non-switched connections for local communication. Deployment and Applications Microsoft is deploying Maia 200 first in its US Central datacenter region near Des Moines, Iowa, with the US West 3 region near Phoenix, Arizona, planned next. The chip will run OpenAI’s GPT-5.2 models and support Microsoft Foundry and Microsoft 365 Copilot services. The company’s Superintelligence team intends to use Maia 200 for synthetic data generation and reinforcement learning. Microsoft states the chip’s architecture enables faster production of domain-specific training data for developing future AI models. Development Ecosystem Microsoft is releasing a Maia SDK preview that includes PyTorch integration, a Triton compiler, optimized kernel libraries, and access to the chip’s low-level programming language. The toolkit also provides a simulator and cost calculator for developers to optimize code before deployment. The company employed pre-silicon modeling to validate the system architecture before manufacturing. According to Microsoft, AI models were running on Maia 200 within days of receiving packaged chips, and the time from first silicon to datacenter deployment was less than half that of comparable infrastructure programs. Microsoft has designed Maia 200 with liquid cooling integration and native Azure control plane connectivity for telemetry, diagnostics, and management. The company describes its silicon program as multi-generational, with future iterations already in development. Developers, AI startups, and academic institutions can register for the Maia SDK preview through Microsoft’s dedicated portal. |

Dr. Jakob Jung ist Chefredakteur Security Storage und Channel Germany. Er ist seit mehr als 20 Jahren im IT-Journalismus tätig. Zu seinen beruflichen Stationen gehören Computer Reseller News, Heise Resale, Informationweek, Techtarget (Storage und Datacenter) sowie ChannelBiz. Darüber hinaus ist er für zahlreiche IT-Publikationen freiberuflich tätig, darunter Computerwoche, Channelpartner, IT-Business, Storage-Insider und ZDnet. Seine Themenschwerpunkte sind Channel, Storage, Security, Datacenter, ERP und CRM.

Dr. Jakob Jung is Editor-in-Chief of Security Storage and Channel Germany. He has been working in IT journalism for more than 20 years. His career includes Computer Reseller News, Heise Resale, Informationweek, Techtarget (storage and data center) and ChannelBiz. He also freelances for numerous IT publications, including Computerwoche, Channelpartner, IT-Business, Storage-Insider and ZDnet. His main topics are channel, storage, security, data center, ERP and CRM.

Kontakt – Contact via Mail: jakob.jung@security-storage-und-channel-germany.de