| Globus entwickelt eine Software-as-a-Service-Infrastruktur für das Forschungsdatenmanagement, wie Executive Director Rachana Ananthakrishnan bei der IT Press Tour zeigte. | Globus, a non-profit platform operated by the University of Chicago, develops its software-as-a-service infrastructure for research data management, as presented by Executive Director Rachana Ananthakrishnan at IT Press Tour. |

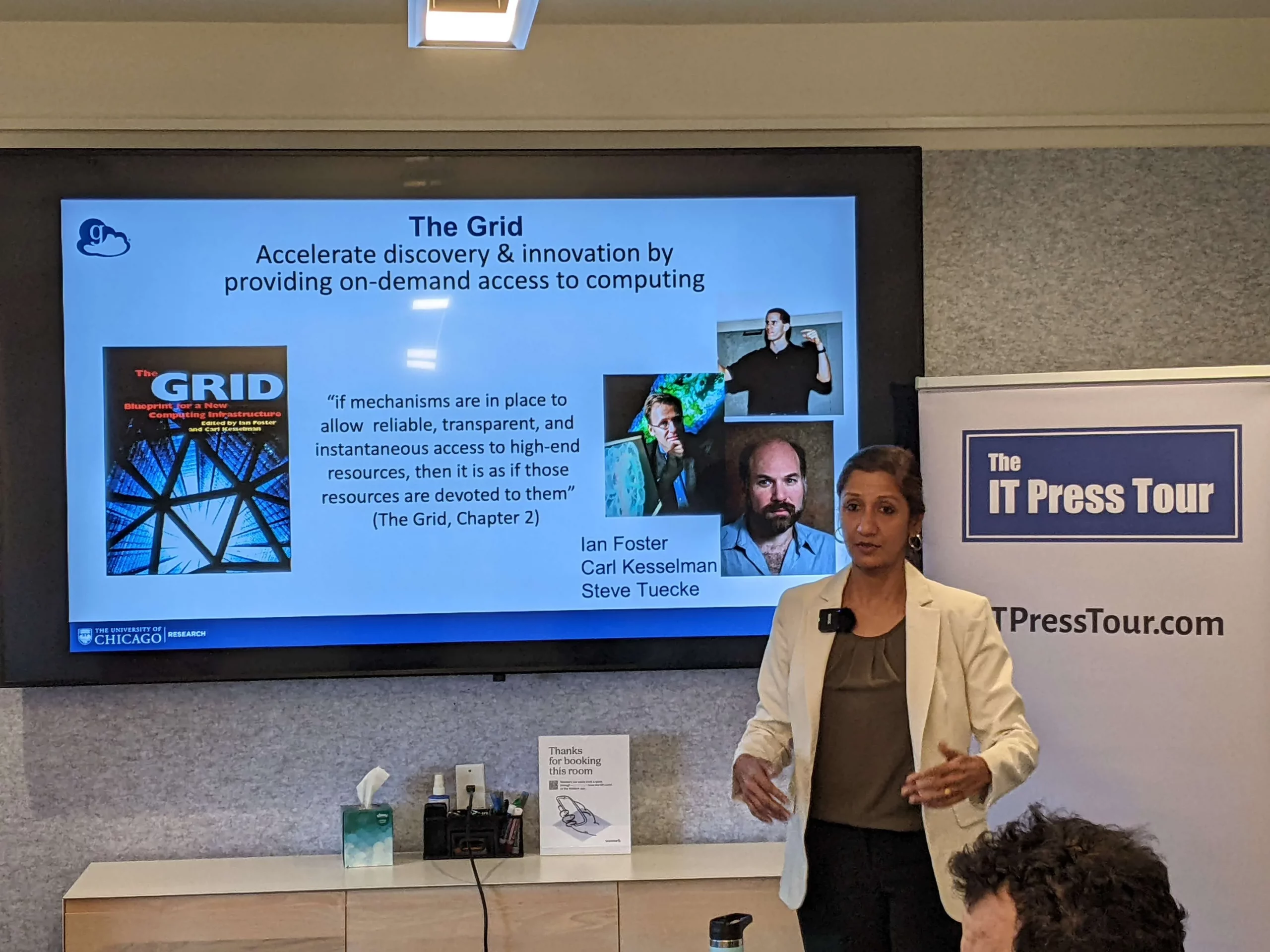

| Die Organisation Globus geht auf das Globus-Projekt der Universität Chicago zurück, das 1997 unter der Leitung von Ian Foster, Carl Kesselman und Steve Tuecke ins Leben gerufen wurde. Das Projekt führte das Konzept des „Grid“ ein, das darauf abzielte, On-Demand-Zugriff auf verteilte Rechenressourcen zu ermöglichen. Das Globus Toolkit, das seit 1998 als Open Source verfügbar ist, fand breite Anwendung in Forschungseinrichtungen und spielte eine Rolle bei drei mit dem Nobelpreis ausgezeichneten Projekten: der IPCC-Klimabewertung 2007, der Entdeckung des Higgs-Bosons am CERN 2013 und der Detektion von Gravitationswellen durch die LIGO-Kollaboration 2017.

Der Übergang vom Toolkit zum cloudbasierten Dienst begann 2010. Globus Online wurde 2011 als Software-as-a-Service-Plattform eingeführt, wodurch das Modell von herunterladbaren Entwicklertools zu einer gehosteten Infrastruktur wechselte. Die Umbenennung in „Globus“ im Jahr 2014 ging mit einer Erweiterung der Funktionen über die Datenübertragung hinaus einher. Laut Messungen bedient die Plattform mittlerweile 200.000 Nutzer in 14.000 Organisationen in 88 Ländern. Das System verarbeitet monatlich 900 Petabyte an Datenverkehr, wobei der Schwerpunkt auf Genomsequenzierungszentren, Synchrotron-Einrichtungen und nationalen Laboratorien liegt. Zu den aktuellen Entwicklungsschwerpunkten gehören Speichersystemanalysen, integrierte Plattformlösungen und die Unterstützung von KI-Systemen, die auf Forschungs-Cyberinfrastrukturen zugreifen. Die Organisation arbeitet auch daran, die Anforderungen zusätzlicher Compliance-Regelungen zu erfüllen, da Forschungseinrichtungen mit zunehmenden regulatorischen Verpflichtungen konfrontiert sind. Die aktuelle Plattform basiert auf einer hybriden Architektur. Cloud-gehostete Dienste übernehmen die Orchestrierung und Verwaltung, während lokale Agenten, die in den Einrichtungen der Institutionen installiert sind, die eigentlichen Datenoperationen verwalten. Durch dieses Design kann die Plattform über verschiedene Sicherheitsgrenzen und Speichersysteme hinweg arbeiten, ohne dass Daten über eine zentralisierte Infrastruktur übertragen werden müssen. Zu den Kernfunktionen gehören die verwaltete Datenübertragung mit automatisierten Wiederholungsmechanismen, die sichere Datenfreigabe mit granularen Zugriffskontrollen und der föderierte Zugriff über mehrere Speichersysteme hinweg. Die Plattform unterstützt Übertragungen zwischen lokalen Speichern, Cloud-Anbietern, Laptops und Instrumenteneinrichtungen. Ein Community Connector Program ermöglicht die Integration mit zusätzlichen Speichersystemen über ein offenes Ökosystem. Die jüngsten Entwicklungen konzentrierten sich auf das Rechenmanagement und die Automatisierung von Arbeitsabläufen. Globus Compute ermöglicht die Remote-Ausführung von Funktionen über verteilte Ressourcen hinweg unter Verwendung von Python. Globus Flows bietet Workflow-Orchestrierung mit einem ereignisgesteuerten Ausführungsmodell. Diese Komponenten erfüllen die Anforderungen für die Verarbeitung von Daten aus wissenschaftlichen Instrumenten und die Koordination mehrstufiger Forschungspipelines. Die Plattform implementiert Sicherheitskontrollen, die den Standards NIST 800-53 und 800-171 entsprechen. Die University of Chicago unterhält eine Geschäftspartnervereinbarung mit Cloud-Anbietern, um die Verarbeitung geschützter Gesundheitsdaten und anderer eingeschränkter Datentypen gemäß der DSGVO und ähnlichen regulatorischen Rahmenwerken zu unterstützen. Die Nutzung umfasst sowohl den akademischen als auch den kommerziellen Sektor. Zu den abonnierenden Institutionen gehören Forschungsuniversitäten, nationale Laboratorien, Supercomputing-Zentren, Genomsequenzierungszentren und Pharmaunternehmen. Zu den europäischen Abonnenten gehören die Max-Planck-Computing-and-Data-Facility (MPCDF) (ehemals Rechenzentrum Garching), die Universität Düsseldorf, das Leibniz Supercomputing Rechenzentrum der Bayerischen Akademie der Wissenschaften in Garching, die European Synchrotron Radiation Facility, die ETH Zürich und mehrere britische Forschungsinstitute, darunter das Wellcome Trust Sanger Institute und Genomics England. Das Umsatzmodell basiert auf einem Freemium-Modell. Die Grundfunktionen stehen für nichtkommerzielle Forschungszwecke weiterhin kostenlos zur Verfügung. Abonnements schalten erweiterte Funktionen frei, heben Nutzungsbeschränkungen auf und bieten Zugang zu konformitätszertifizierten Konfigurationen. Die Preisgestaltung folgt einer pauschalen Jahresstruktur, die sich nach den Forschungsausgaben der Einrichtung richtet und nicht nach der Anzahl der Nutzer oder dem Datenvolumen. Kommerzielle Abonnenten zahlen Premium-Tarife. Die Plattform steht vor den üblichen Herausforderungen, die mit der Forschungs-Computing-Infrastruktur einhergehen: Aufrechterhaltung der Interoperabilität zwischen heterogenen Systemen, Unterstützung immer komplexerer Anforderungen an den Datenaustausch und Skalierung, um dem Wachstum des Datenvolumens aus fortschrittlichen Instrumenten gerecht zu werden. Der Wandel hin zu KI-gesteuerten Forschungsabläufen bringt zusätzliche Anforderungen an die Verwaltung von Trainingsdatensätzen und die Koordinierung von Rechenressourcen über institutionelle Grenzen hinweg mit sich. |

The Globus organization traces its origins to the Globus Project, launched in 1997 under the direction of Ian Foster, Carl Kesselman, and Steve Tuecke. The project introduced the concept of „the Grid,“ which aimed to provide on-demand access to distributed computing resources. The Globus Toolkit, released in open-source form beginning in 1998, became widely adopted across research institutions and played a role in three Nobel Prize-winning efforts: the 2007 IPCC climate assessment, the 2013 discovery of the Higgs Boson at CERN, and the 2017 detection of gravitational waves by the LIGO collaboration.

The transition from toolkit to cloud-based service began in 2010. Globus Online launched in 2011 as a software-as-a-service platform, shifting the model from downloadable developer tools to hosted infrastructure. The rebranding to „Globus“ in 2014 accompanied expanded capabilities beyond data transfer. According to metrics, the platform now serves 200,000 users across 14,000 organizations in 88 countries. The system processes 900 petabytes of data movement monthly, with particular concentration in genome sequencing centers, synchrotron facilities, and national laboratories. Current development priorities include storage system analytics, integrated platform solutions, and support for AI systems accessing research cyberinfrastructure. The organization also works to meet requirements of additional compliance regimes as research institutions face expanding regulatory obligations. The current platform operates on a hybrid architecture. Cloud-hosted services handle orchestration and management, while local agents installed at institutional facilities manage actual data operations. This design allows the platform to work across different security boundaries and storage systems without requiring data to move through centralized infrastructure. Core capabilities include managed data transfer with automated retry mechanisms, secure data sharing with granular access controls, and federated access across multiple storage systems. The platform supports transfers between on-premises storage, cloud providers, laptops, and instrument facilities. A Community Connector Program allows integration with additional storage systems through an open ecosystem. Recent development has focused on compute management and workflow automation. Globus Compute enables remote function execution across distributed resources using Python. Globus Flows provides workflow orchestration with an event-driven execution model. These components address requirements for processing data from scientific instruments and coordinating multi-step research pipelines. The platform implements security controls aligned with NIST 800-53 and 800-171 standards. The University of Chicago maintains a Business Associate Agreement with cloud providers to support handling of protected health information and other restricted data types under GDPR and similar regulatory frameworks. Adoption includes both academic and commercial sectors. Subscriber institutions span research universities, national laboratories, supercomputing centers, genome sequencing facilities, and pharmaceutical companies. European subscribers include the Max Planck Computing and Data Facility, European Synchrotron Radiation Facility, ETH Zurich, and multiple UK research institutes including the Wellcome Trust Sanger Institute and Genomics England. The revenue model operates on a freemium basis. Basic features remain available without charge for non-profit research use. Subscriptions unlock enhanced features, remove usage limits, and provide access to compliance-certified configurations. Pricing follows a flat annual structure determined by institutional research expenditure levels rather than user counts or data volumes. Commercial subscribers pay premium rates. The platform faces ongoing challenges inherent to research computing infrastructure: maintaining interoperability across heterogeneous systems, supporting increasingly complex data-sharing requirements, and scaling to accommodate growth in data volumes from advanced instruments. The shift toward AI-driven research workflows adds requirements for managing training datasets and coordinating compute resources across institutional boundaries. |

Dr. Jakob Jung ist Chefredakteur Security Storage und Channel Germany. Er ist seit mehr als 20 Jahren im IT-Journalismus tätig. Zu seinen beruflichen Stationen gehören Computer Reseller News, Heise Resale, Informationweek, Techtarget (Storage und Datacenter) sowie ChannelBiz. Darüber hinaus ist er für zahlreiche IT-Publikationen freiberuflich tätig, darunter Computerwoche, Channelpartner, IT-Business, Storage-Insider und ZDnet. Seine Themenschwerpunkte sind Channel, Storage, Security, Datacenter, ERP und CRM.

Dr. Jakob Jung is Editor-in-Chief of Security Storage and Channel Germany. He has been working in IT journalism for more than 20 years. His career includes Computer Reseller News, Heise Resale, Informationweek, Techtarget (storage and data center) and ChannelBiz. He also freelances for numerous IT publications, including Computerwoche, Channelpartner, IT-Business, Storage-Insider and ZDnet. His main topics are channel, storage, security, data center, ERP and CRM.

Kontakt – Contact via Mail: jakob.jung@security-storage-und-channel-germany.de